AI-blunder pakt duur uit voor Google: chatbot verzint feiten

Een fout antwoord op een voorbeeldvraag heeft Google tientallen miljarden gekost op Wall Street. De prijs van aandelen kelderde 8 procent toen bleek dat een reclameboodschap voor de nieuwe chatbot juist perfect de beperkingen illustreert van deze nieuwe kunstmatige intelligentie.

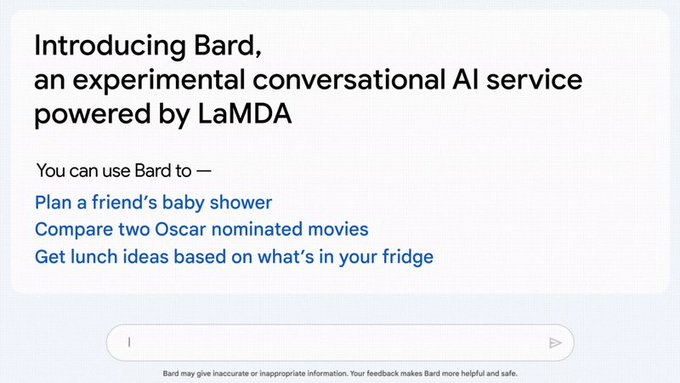

Google introduceerde de nieuwe dienst Bard deze week, als antwoord op een soortgelijk initiatief van Microsoft, dat de geavanceerde tekstgenerator ChatGPT integreerde in zijn zoekdienst Bing. In beide gevallen wordt kunstmatige intelligentie gebruikt om zoekresultaten in een samenhangend verhaal te presenteren.

Dat moet het mogelijk maken gedetailleerd antwoord te krijgen op specifieke zoekvragen. Je kunt bijvoorbeeld vragen om reistips voor een vijfdaagse reis naar Londen of een samenvatting van wat er trending is op Twitter. Bard ging echter de mist in bij de vraag "Wat kan ik mijn 9-jarige vertellen over de ontdekkingen van de James Webb-ruimtetelescoop".

Behalve de juiste antwoorden dat de telescoop bijvoorbeeld superoude sterrenstelsels had gefotografeerd, beweerde Bard ook dat de telescoop "de eerste foto's van een planeet buiten ons eigen zonnestelsel heeft genomen". Echter, foto's van dergelijke exoplaneten werden al in 2004 gemaakt door de Very Large Telescope.

De fout komt voorbij in deze uitleg van Google:

"Als iemand die 14 jaar voor de Webbtelescoop een afbeelding van een exoplaneet maakte, denk ik dat je misschien een ander voorbeeld moet vinden", suggereerde astronoom Bruce Macintosh droog toen persbureau Reuters de fout ontdekte. Ironisch genoeg gaf de oude vertrouwde zoekmachine van Google wel het juiste antwoord, merkten anderen op.

Dat de fout gisteren werd ontdekt is extra pijnlijk omdat het bedrijf toen een presentatie gaf vanuit Parijs over alle AI-innovaties waar het aan werkt. Die heeft Wall Street weinig vertrouwen gegeven.

In een reactie zegt Google dat er nog hard wordt gewerkt om kinderziektes uit het systeem te halen voordat het breed wordt uitgerold. Zo worden er vanaf deze week testers ingezet om de resultaten betrouwbaarder te maken.

Hallucineren

Experts wijzen al langer op dit soort fouten door AI-programma's. Het wordt hallucineren genoemd, omdat de bot zeer overtuigend totale onzin achter elkaar zet. "Deze systemen zijn bedoeld om plausibele antwoorden te geven op basis van statistische analyse - ze zijn niet ontworpen om waarheidsgetrouw te antwoorden", legt AI-expert Carissa Véliz van Oxford University uit aan New Scientist.

In dit geval lijkt Bard te zijn verward door berichten over de eerste keer dat de Webb-telescoop exoplaneten vastlegde. Dat ging specifiek over Webbs eerste keer, maar werd door Bard geïnterpreteerd als de eerste keer ooit.

Beleggers schrokken van de fout: op Wall Street verloor het bedrijf gisteren bijna 8 procent van zijn waarde, rond de 100 miljard euro. Bard moet ervoor zorgen dat Google marktleider blijft in zoekmachines, en zo'n miskleun ondermijnt het vertrouwen daarin.

Helderziend

Overigens is ook de grote rivaal, ChatGPT van Microsofts Bing, niet vrij van kinderziektes. Op de vraag van persbureau AP wat het grootste sportnieuws van de afgelopen 24 uur was, zei de zoekmachine niets over bijvoorbeeld het record van LeBron James, maar vertelde het in geuren en kleuren over de uitslag van de Superbowl, een wedstrijd die pas zondag wordt gespeeld.

"Het was een spannende wedstrijd tussen de Philadelphia Eagles en de Kansas City Chiefs, twee van de beste teams in de NFL dit seizoen. De Eagles, geleid door quarterback Jalen Hurts, wonnen hun tweede Lombardi Trofee door de Chiefs, geleid door quarterback Patrick Mahomes, te verslaan met 31-28." De bot verzon er voor de volledigheid ook nog wat specifieke wedstrijdstatistieken bij en noemde welke drie liedjes Rihanna zou zingen "in een spectaculaire pauzeshow".

"Dit onderstreept de problemen van het hallucineren door AI-programma's," concludeerde AP, "tenzij Bing helderziend is - daar zullen we zondag achterkomen."